基石智算CoresHub 全面升級了模型推理服務(wù)!用戶可在魔搭、huggingface 等下載模型到基石智算,通過模型推理服務(wù)進(jìn)行一鍵部署推理服務(wù),并對外提供 API 能力,也可經(jīng)過基石智算的模型調(diào)優(yōu)進(jìn)行二次訓(xùn)練后再部署。

推理過程中可以根據(jù)業(yè)務(wù)的并發(fā)量,進(jìn)行推理服務(wù)的彈性擴縮容,提高業(yè)務(wù)運行效率的同時,節(jié)省算力成本。

以下是通過模型推理服務(wù)一鍵部署模型的詳細(xì)步驟,以魔搭下載的模型為例:

一、從魔搭下載模型到文件存儲

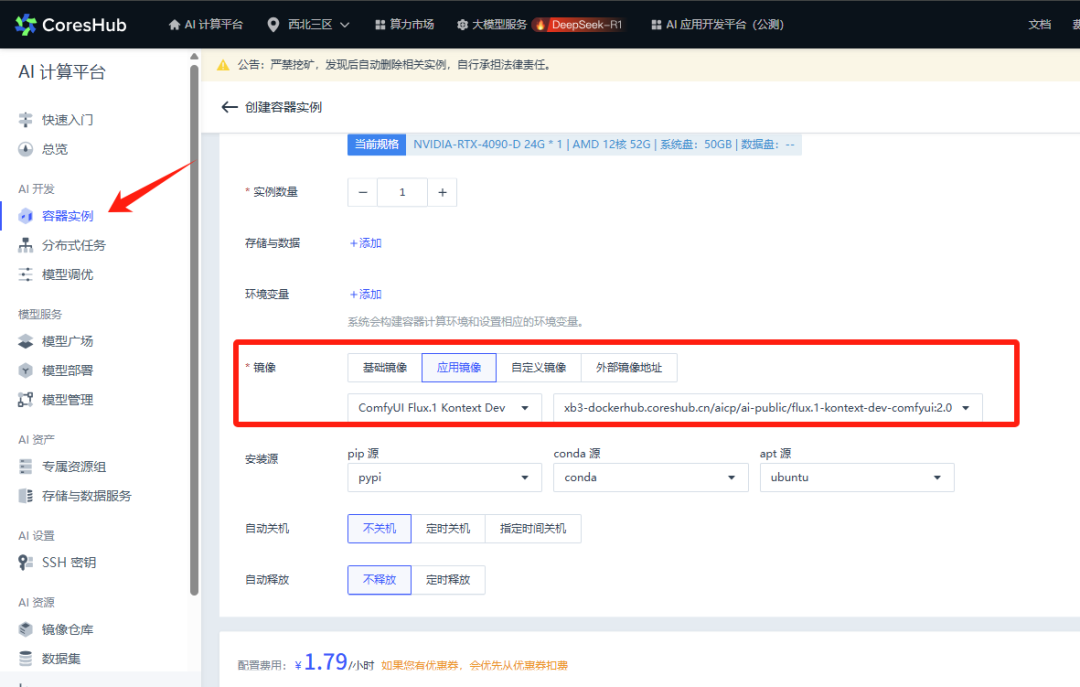

1. 創(chuàng)建存儲目錄。

2. 創(chuàng)建一個用于傳數(shù)據(jù)的無卡啟動實例,掛載文件存儲。

3. 在 Web 連接窗口中輸入如下命令:

進(jìn)入文件存儲中

# cd epfs

安裝 git-lfs 的軟件包

# apt install git-lfs

4. 查看魔搭中的“模型文件—模型下載—下載”命令,使用 Git 下載

在 Web 連接中繼續(xù)執(zhí)行以下步驟:

# git lfs install

# git clone https://www.modelscope.cn/deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B.git

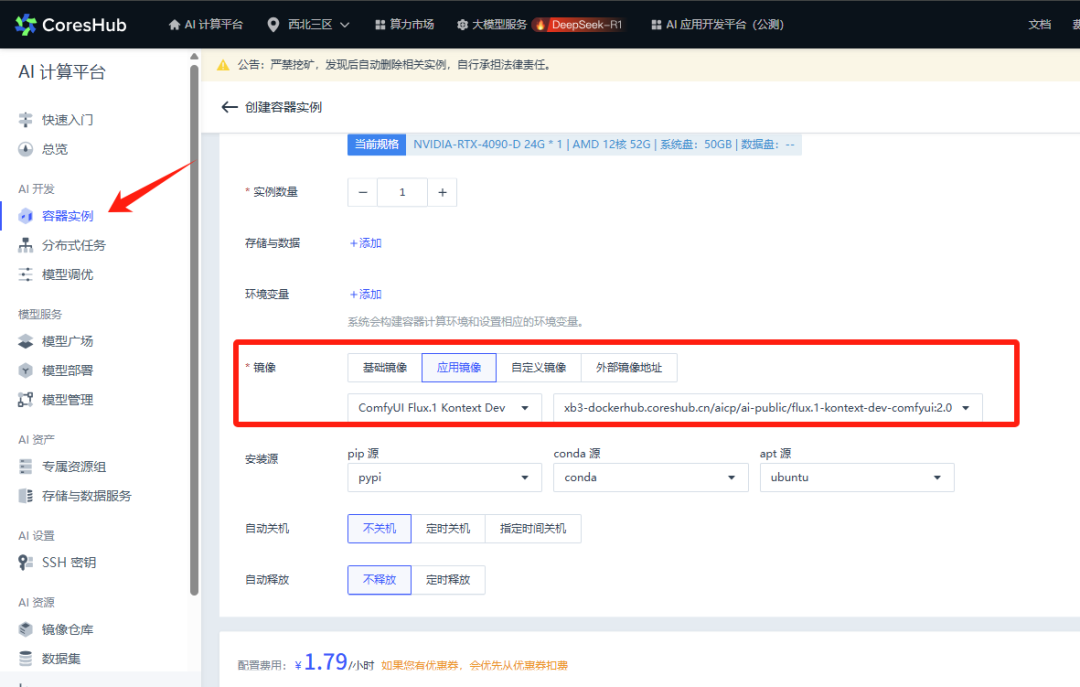

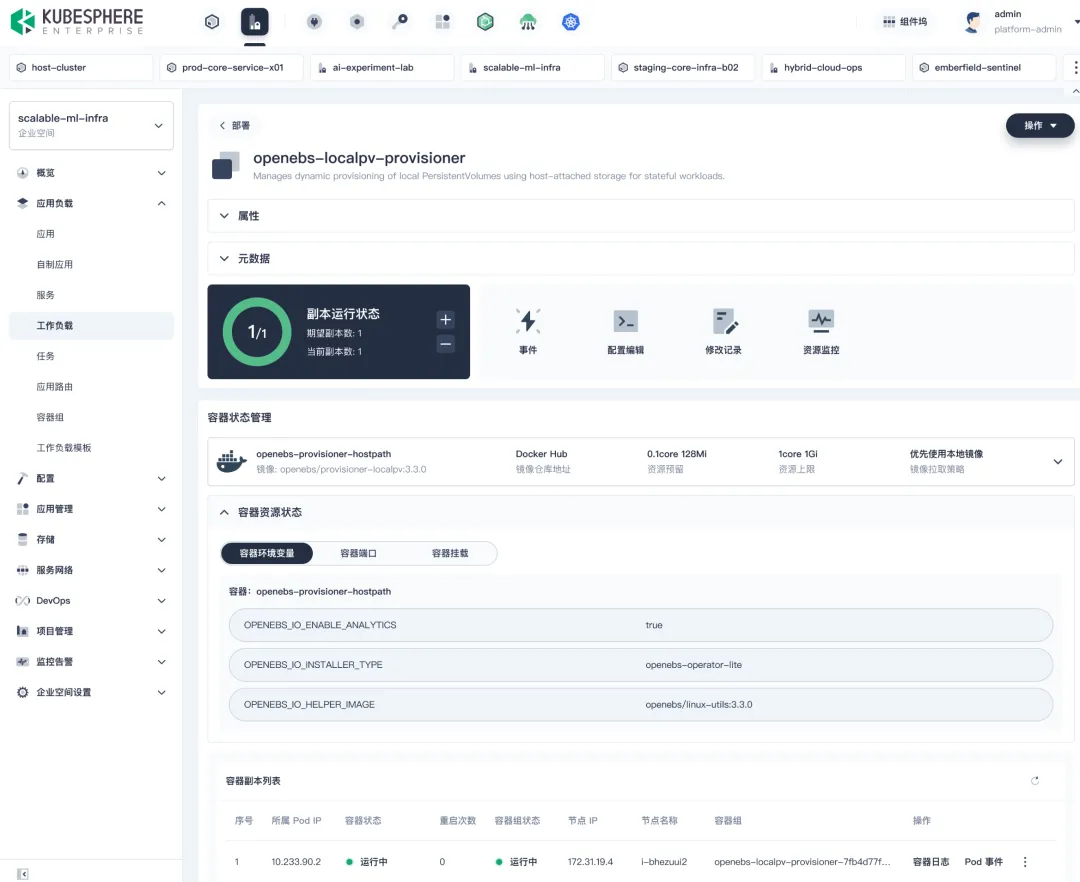

二、模型部署

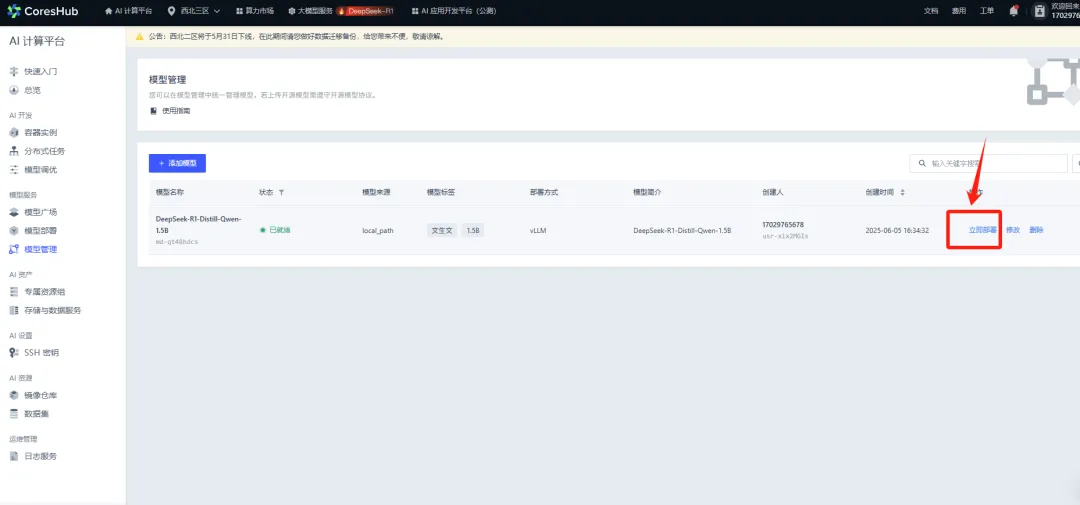

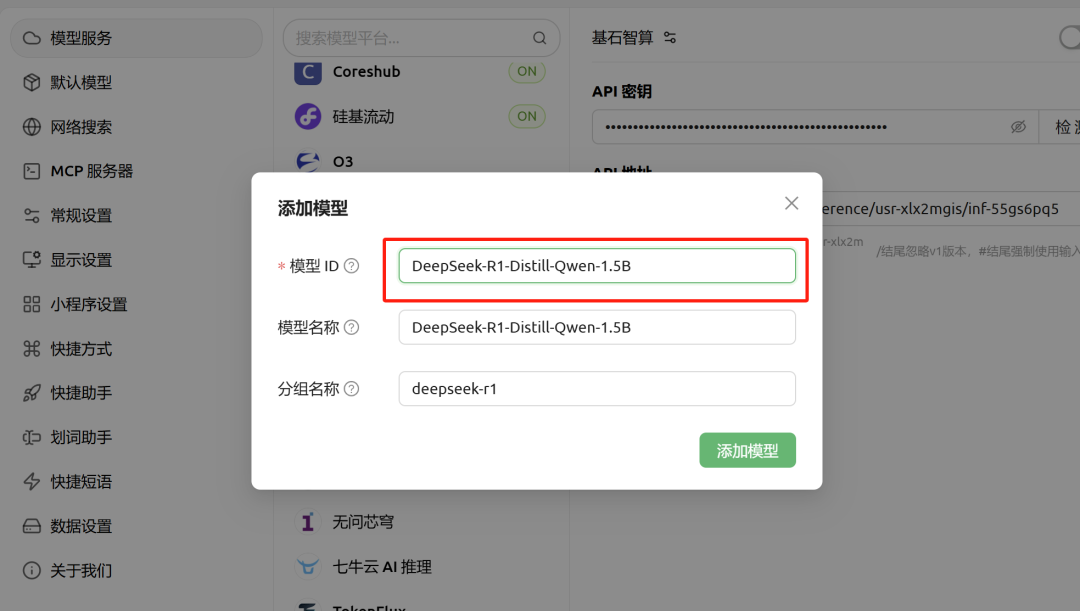

1. 到“模型管理”添加模型。

選擇已下載的模型。

輸入模型名稱等信息,選擇部署方式。

2. 部署模型

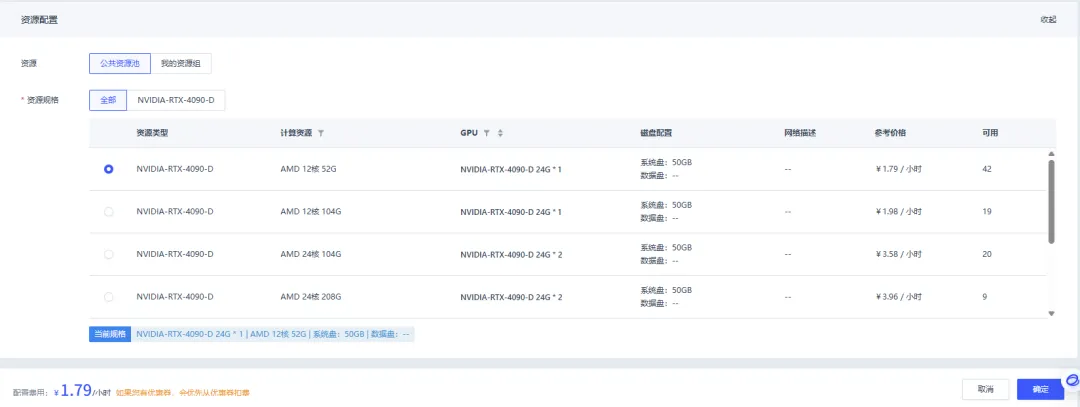

選擇部署方式,支持單節(jié)點和多節(jié)點部署。

選擇資源類型。

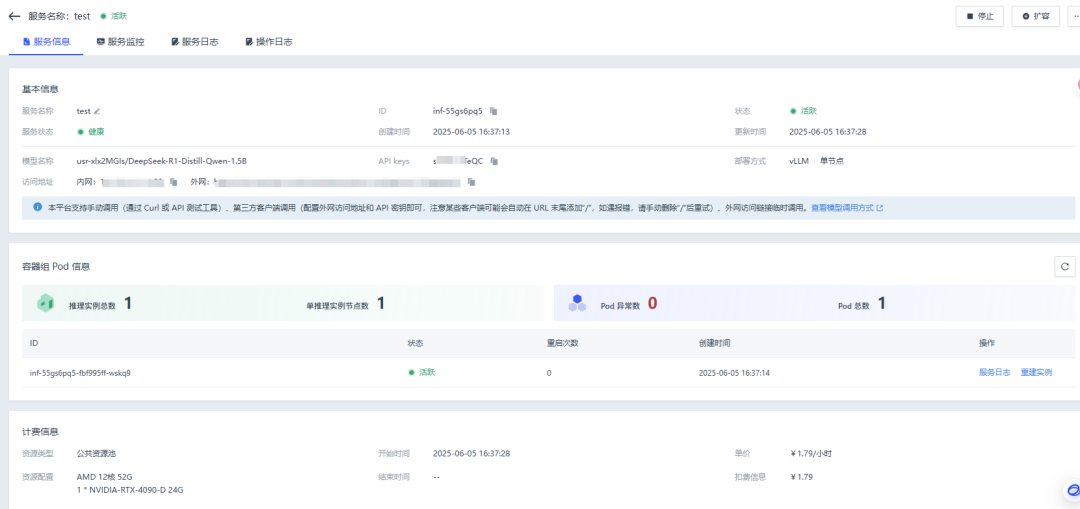

部署成功后,點擊服務(wù) ID 即可查看服務(wù)信息、服務(wù)監(jiān)控、服務(wù)日志。

3. 支持?jǐn)U容

當(dāng)推理服務(wù)需要滿足更高并發(fā)時,可以通過增加推理實例的數(shù)量,以滿足業(yè)務(wù)的高并發(fā)需求。

假設(shè) 1 張 4090 可以滿足 DeepSeek-R1-1.5B 最高 100 的并發(fā)數(shù)量,當(dāng)業(yè)務(wù)并發(fā)超出 100,可以增加到 2 個 4090 的 1 卡實例進(jìn)行模型部署。

三、 模型調(diào)用

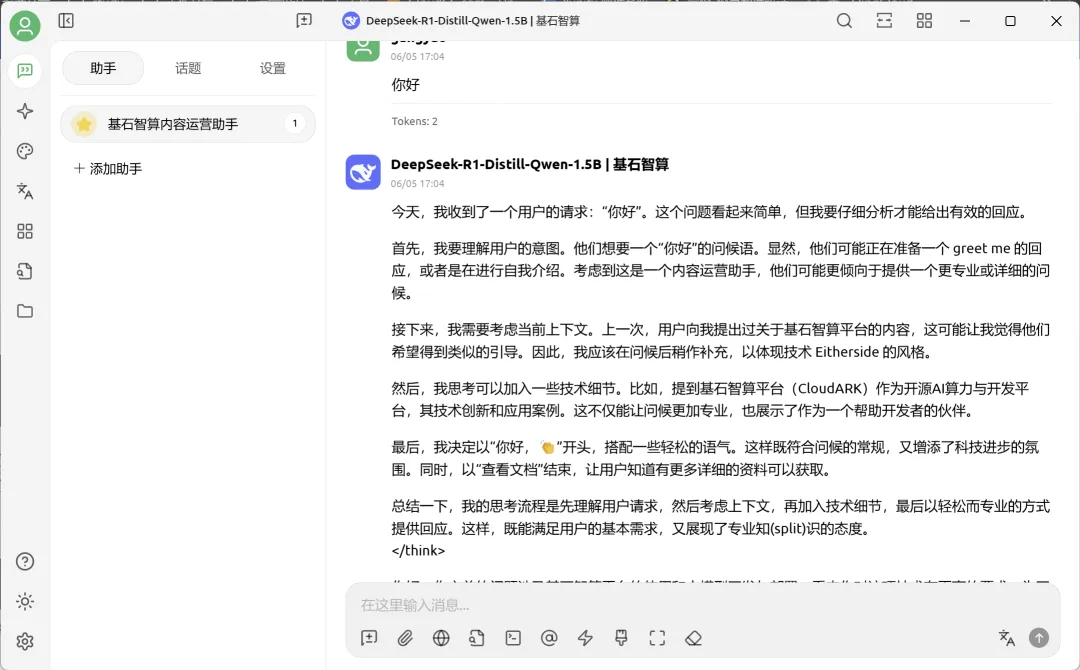

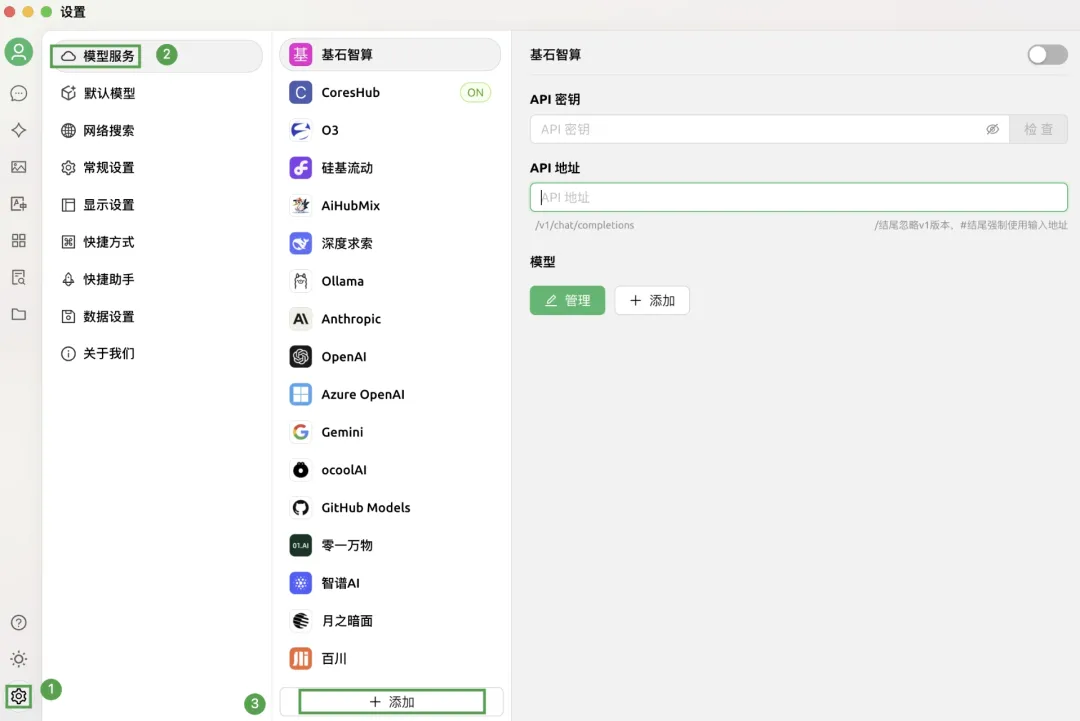

1. 使用第三方客戶端 Cherry Studio 調(diào)用為例,開啟第三方工具,點擊界面左下角的設(shè)置圖標(biāo),選擇模型服務(wù) > 添加。

2. 在彈出添加提供商窗口中,配置各項參數(shù),點擊確定。

3. 新添加的提供商已顯示在列,配置相應(yīng)的 API 密鑰和 API 路徑,并點擊管理,對應(yīng)的密鑰和 API 地址在服務(wù)信息中。

4. 配置模型名稱。

5. 在 CherryStudio 平臺,點擊左側(cè)導(dǎo)航欄中的聊天助手,在對話框的頂部,切換已添加至平臺上的模型,即可對話。